NVIDIA

SK하이닉가 연이어 엔비디아의 파트너로 낙점될 가능성이 높아졌다. 이렇게 되면 SK하이닉스가 고대역폭 메모리(HBM)의 선두 주자 자리를 공고히 할 것으로 예상된다.

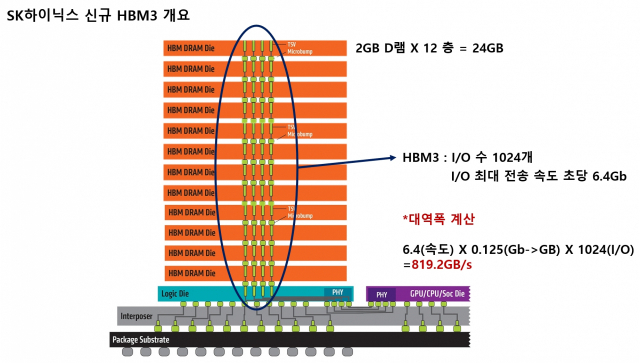

반도체 업계는 엔비디아가 자사 최신 그래픽 칩인 H100의 성능을 한층 더 끌어올리기 위해 SK하이닉스에 차세대 HBM인 HBM3E 샘플을 요청했을 것이라고 보고 있다. AI 용 그래픽 칩의 성능을 끌어올리기 위해선 고성능·고용량 메모리반도체를 사용해 입출력 속도를 높이는 것이 관건이다. 기존 H100엔 현존 최고 사양 D램인 HBM3가 적용된다. HBM3E는 그 다음 세대다. SK하이닉스는 내년 초 양산을 목표로 하고 있다.

HBM이 GPU와 결합해 쓰이는만큼, 성능 평가는 출시 전 필수적인 과정이다. 메모리반도체 제조사로선 고객사들에게 기술력을 입증하는 중요 관문이기도 하다. SK하이닉스가 이를 통과할 경우 4세대인 HBM3를 엔비디아에 공급한 것에 이어 연달아 5세대 HBM3E까지 엔비디아에 납품하게 된다.

SK하이닉스는 2013년 세계 최초로 HBM을 개발한 후 시장 선두 자리를 지켜왔다. 시장조사업체 트렌드포스에 따르면 지난해 기준 HBM 글로벌 시장점유율은 SK하이닉스가 50%, 삼성전자가 40%, 마이크론이 10%였다. 현존 최고 성능 D램인 HBM3를 대량 양산하는 곳은 SK하이닉스가 유일하다. 경쟁사인 삼성전자와 마이크론은 올해 말이나 내년 초에 양산할 것으로 전망된다. 국내 메모리반도체 업계 관계자는 "GPU 성능을 높여야 하는 엔비디아로선 SK하이닉스의 다음 세대 제품을 선택하는 것이 당연한 수순일 것"이라고 말했다.

AI반도체는 깊은 불황에 빠진 반도체 업계를 상승전환시킬 구세주로 평가받고 있다. 수혜를 받을 것으로 여겨지는 대표 비메모리제품이 GPU, 메모리는 HBM 등 고성능 제품이다.

AI반도체 시장에 사용되는 엔비디아의 GPU 점유율은 90%가 넘는다. H100은 가장 최신 규격으로, 최근 물량 주문이 쏟아지는 것으로 전해진다. 챗GPT 개발사인 오픈AI가 최근 출시한 대규모 언어모델(LLM) 'GPT-4'에도 엔비디아의 H100 칩이 1만여개 들어갔다. AI열풍에 엔비디아는 지난달 30일 반도체 기업으로서는 사상 처음으로 시가총액 1조달러를 달성하기도 했다.

이 때문에 지난해 하반기부터 불황 직격탄을 맞은 국내 메모리반도체 업체로서도 HBM은 놓칠 수 없는 시장이다. 고부가가치, 고수익 제품으로 수익성을 꾀해야 하기 때문이다. HBM의 가격은 일반 D램보다 2~3배 높은데, AI 반도체 열풍이 불면서 최근엔 5배까지 오르기도 했다. 현재로선 D램 시장에서 차지하는 비중이 적지만 성장 가능성은 크다. 트렌드포스는 HBM 시장 규모가 올해부터 2025년까지 연평균 최대 45% 이상 성장할 것이라고 봤다.

AMD

AMD의 차세대 AI 반도체에 삼성전자, SK하이닉스의 HBM(고대역폭메모리)가 함께 채택됐다. AMD가 이번 신제품을 통해 AI 반도체 시장을 적극 공략할 예정인 만큼, 국내 주요 메모리업체들도 HBM 사업의 저변을 확대할 수 있을 것이라는 기대감이 나온다.

6월 15일 업계에 따르면 삼성전자, SK하이닉스는 AMD의 최신형 GPU 제품 'MI300'의 HBM3 공급업체로 동시 진입했다.

MI300은 AI·HPC 등 데이터센터 시장을 겨냥해 제작된 고성능 AI 반도체다. AMD는 지난 1월 MI300A를 공개한 데 이어, 지난 13일(현지시간)에는 보다 성능을 높인 MI300X를 공개했다. 두 칩은 각각 128GB, 192GB 용량의 HBM3를 탑재한다.

HBM은 여러 개의 D램을 수직으로 쌓아 올린 최첨단 메모리반도체다. 기존 D램 대비 대역폭이 넓어 데이터를 효율적이고 빠르게 전송할 수 있다. 지난 2013년 1세대 제품을 시작으로 HBM3는 HBM의 가장 최신 세대인 4세대 제품에 해당한다.

AMD는 이 MI300 시리즈에 필요한 HBM3 제품을 삼성전자, SK하이닉스로부터 모두 공급받을 것으로 알려졌다.

사안에 정통한 관계자는 "AMD가 삼성전자와 SK하이닉스에 모두 HBM 공급을 요청했고, 이에 두 메모리업체 모두 벤더로 진입할 예정"이라며 "AMD도 최근 고성능 메모리 수급량이 증가하고 있어 듀얼 벤더를 채택하는 경우가 많다"고 설명했다.

이로써 삼성전자, SK하이닉스는 나란히 HBM 시장 확대를 가속화할 기회를 잡게 됐다.

시장조사업체 딜로이트에 따르면 AMD의 주요 경쟁사인 엔비디아는 올해 초 기준 AI 반도체 시장 점유율 90% 이상을 확보하며 선두를 달리고 있다. 지난해 하반기에는 SK하이닉스의 HBM3를 탑재한 차세대 GPU 'H100' 양산에도 나섰다. AMD는 후발주자로서 공급을 적극 확대해야 하는 상황이다.

MI300X는 최대 192GB의 메모리가 지원되는 인공지능 반도체로 거대언어모델(LLM)을 개발하기 위한 용도로 설계된 제품인데 HBM3이 지원된다.

HBM은 램을 여러 층으로 쌓아올린 형태로 구현돼 인공지능처럼 수많은 데이터를 빠르게 처리해야 하는 분야에서 활용되는 고성능 메모리반도체다. 1세대(HBM)-2세대(HBM2)-3세대(HBM2E)-4세대(HBM3) 순으로 개발되고 있다.

삼성전자는 올해 9월부터 HBM3를 양산해 AMD에 본격적으로 공급하기 시작할 것으로 전망된다.

SK하이닉스는 삼성전자보다 한 발 앞서 HBM3 양산을 시작했으며 이미 엔비디아의 인공지능(AI) 서버용 그래픽처리장치(GPU)인 H100에 SK하이닉스 HBM3이 탑재되고 있다.

인공지능 반도체에서 ‘삼성전자-AMD’와 ‘SK하이닉스-엔비디아’의 경쟁구도가 형성되고 있는데, 현재로서는 SK하이닉스-엔비디아 동맹이 훨씬 앞서있는 것으로 평가된다.

엔비디아가 글로벌 인공지능 반도체시장에서 90%를 넘는 점유율을 확보하며 사실상 독점체제를 구축하고 있지만 AMD가 가격경쟁력을 앞세워 엔비디아의 점유율을 잠식해 나갈 수 있을 것으로 관측된다.

AMD의 MI300X는 경쟁제품인 엔비디아 H100보다 훨씬 저렴할 것으로 예상되는데 일각에서는 H100의 3분의 1 수준으로 가격이 책정됐다는 추정이 나온다. H100은 1개 패키지당 가격이 3만 달러(약 3800만 원)에 이른다.

MI300X는 엔비디아 H100보다 더 많은 HBM3가 들어간다는 점도 삼성전자에게는 긍정적인 요인이다. MI300X는 최대 192GB의 메모리가 지원되는 반면 H100은 120GB 메모리가 지원된다.

해외 IT전문매체 테크스팟은 “데이터센터용 중앙처리장치(CPU)에서는 AMD가 이미 인텔의 확실한 대안으로 자리 잡았다”며 “엔비디아가 강력한 지배력을 행사하고 있는 인공지능 반도체에서 AMD의 등장은 많은 기업들에게 환영받게 될 것”이라고 보도했다.

출처: Business Post, ZDnet Korea, 서울경제

뜨리스땅

https://tristanchoi.tistory.com/450

반도체 기술 탐구: HBM 채택 움직임 - 1. Intel

인텔이 제온 12세대 프로세서와 고대역폭 메모리(HBM)를 결합한 인텔 제온 CPU 맥스 시리즈(코드명 사파이어 래피즈HBM)를 공개했다. 인텔 제온 CPU 맥스 시리즈 프로세서는 칩에 HBM이 내장된 첫 x86

tristanchoi.tistory.com

'반도체, 소.부.장.' 카테고리의 다른 글

| 반도체 기술 탐구: SK Hynix의 HBM 패키징 기술, TSV와 MR-MUF (3) | 2023.07.19 |

|---|---|

| 반도체 기업 탐구: 레이크머티리얼즈 (0) | 2023.06.22 |

| 반도체 기술 탐구: HBM 채택 움직임 - 1. Intel (0) | 2023.06.17 |

| 반도체 기업 탐구: 티에스이 최근 실적 점검(23Q1~Q2) (2) | 2023.05.29 |

| 반도체 산업 탐구: DDR5 효과 지속, 우려대비 견조할 ASP (1) | 2023.05.22 |

댓글