NPU 중심의 데이터센터를 구축하고 있는 테슬라

이러한 NPU의 장점을 가장 잘 활용하여 데이터센터를 구축한 AI 서비스 업체는 테슬라이다.

테슬라의 자율주행 서비스(Full Self Driving)를 구현하기 위한 알고리즘은 이 알고리즘을 학습하기 위한 최적의 NPU인 Tesla Dojo라는 학습용 NPU로 학습되며, 각각의 테슬라 차량에는 HW N.0 시리즈라는 Customized NPU가 탑재되어 있다.

HW N.0 NPU는 자율주행 추론을 위해 특화 설계된 칩이며, 전세계 도심을 누비며 교통상황에 맞는 추론을 하고 그 결과에 따라 차량을 제어한다. 이후 이렇게 쌓인 데이터를 Dojo Chip으로 구동되는 TESLA의 중추서버에 전달하면 해당 서버에서 자율주행 알고리즘 연산에 최적화된 Dojo가 다시 학습을 통해 서비스를 더욱 발전시킨다.

서비스 - 알고리즘 - 학습용 반도체 - AI 가속기의 고리 속에서 모든 소프트웨어(알고리즘)와 하드웨어(칩)를 본인들의 서비스에 최적화하여 운영하는 방식이다.

NPU의 확산을 가지고 올 온디바이스 AI

이러한 데이터센터용 NPU 이외에 최근 들어 AI 산업에서 널리 회자되고 있는 NPU의 응용 방안은 엣지 디바이스의 AI 디바이스화 즉 온디바이스 AI(on-device AI)이다.

쉽게 말해 스마트폰, PC, AR/VR, 자동차 등의 Consumer Product에 가속기를 장착해 AI 모델을 더욱 효율적으로 구동시킬 수 있도록 한다는 것인데 이러한 응용처에 NPU는 적합한 반도체라고 할 수 있다. 엣지 디바이스에 AI 가속기를 장착할 시 디바이스에서 일정 규모의 인공지능 연산이 가능하기 때문에 모든 연산을 중추서버(Backbone Server)와의 통신에 전적으로 의존할 필요가 없다.

그렇다면 이제부터는 중추서버(Backbone Server)와의 통신 없이 곧바로 ChatGPT4 같은 무거운(연산량이 많은) 생성형 AI를 곧바로 구동시킬 수 있을까? 답은 ‘그렇지 않다’이다. 온디바이스에 AI를 구현하는 것에는 NPU의 역할이 가장 중요해질 것인데 아직까지는 성능이 좋은 NPU를 디바이스에 탑재한다고 하여도 챗GPT와 같은 거대 AI 모델을 그 NPU 하나로 구동시킬 수는 없다.

온디바이스 AI가 활용되는 현실적인 예시를 뒤에서 설명하겠지만 연산의 규모가 크지 않은 엣지 디바이스용 AI 서비스(동시 통역, 번역, 문서 작업)가 이러한 NPU를 사용하여 중추서버와의 통신 없이 구동될 것이다. 그리고 챗GPT와 같은 거대 AI 모델에 있어서는 중추 서버와의 통신에 의존하지만 일정 워크로드를 온디바이스에서 해결하여 서비스의 속도(ex. 답변 속도)가 빨라지는 것이 온디바이스 AI의 실제 활용 방안이 될 것이다.

비유를 하자면 마치 PIM(Process In Memory)을 사용하여 일정량의 연산을 미리 처리하면 로직 프로세서가 감당해야 되는 연산의 부담이 줄어드는 것과 비슷한 이치다. 스마트폰 AP, PC용 칩에서 NPU의 기능이 강화되며 연산의 효율성이 극대화되기 때문에 각자가 휴대하고 있는 디바이스에서 더욱 빠른 AI 서비스를 이용할 수 있게 되며 디바이스에 특화된 서비스를 제공받을 수 있게 되는 것이다.

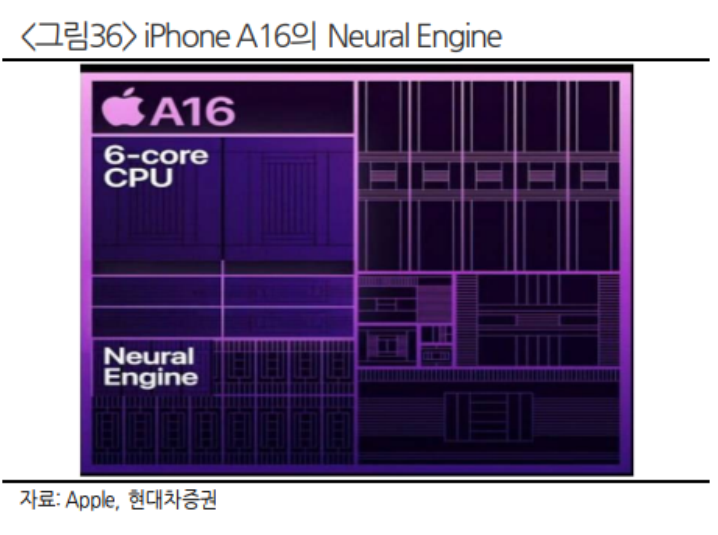

또한 면적의 측면에서도 AI 가속기는 장점을 가지는데 GPU 대비 차지하는 면적이 훨씬 작고, 전력 소모도 적기 때문에 배터리를 사용하는 엣지 디바이스에 더욱 적합하다고 할 수 있다.

스마트폰 거인 Apple도 온디바이스 AI 시장에 참전

스마트폰 시장의 선두주자인 Apple도 온디바이스 AI를 `24년 iPhone 16 Series부터 탑재할 것으로 기대된다. Apple은 이미 200억 달러 이상을 생성형 AI 모델 개발에 투자하고 있고, 이미 지난 `11년 Siri를 출시하며 막대한 데이터도 확보한 상황이다.

2024년 Siri에 생성형 AI가 적용된다면, 사용자의 경험을 학습하며 개인의 맞춤형 비서로 기능하게 된다. 더 이상 ‘아이폰 자동완성 기능’이 재미있는 밈이 아니라 통번역, 문서작업, 음악감상 등에서 사용자의 편리성이 극대화되는 것이다.

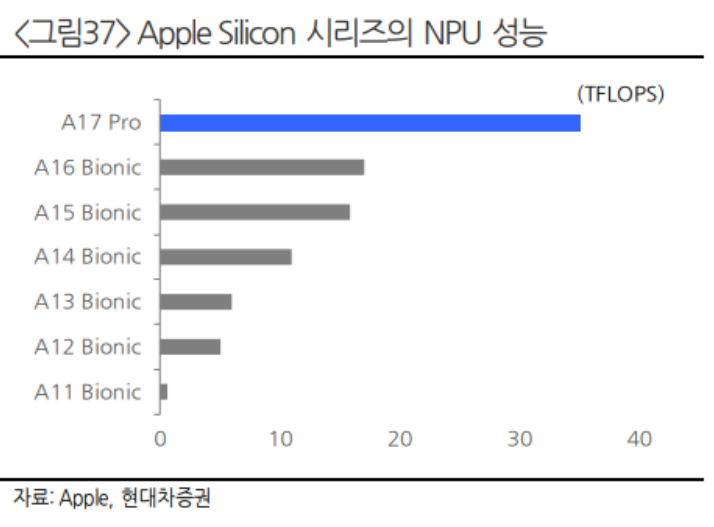

애플은 `17년 iPhone X에 탑재한 A11 Bionic 칩부터 이미 NPU를 내장하기 시작했으며 지난 6년간 NPU 코어 수와 성능은 (A11 Bionic 2코어, 600 GOPS A17 Pro 16코어 35TOPS) 급격히 증가했다. 아직 정식 공개는 되지 않았으나 지난 수 년간 Apple은 이미 온디바이스 AI를 위한 역량을 쌓고 있었다. Apple Silicon과 막대한 데이터를 기반으로 한 Apple의 새로운 생성형 AI에 주목할 필요가 있을 것이다.

퀄컴의 AP 스냅드래곤8 젠 3와 X-Elite는 온디바이스 AI 를 위한 전용 칩

퀄컴은 `24년부터 자사 스냅드래곤8 3세대 칩에 최대 100억개의 파라미터를 지원하는 NPU를 탑재(2세대 대비 98% 성능 향상)하며, 메타의 생성형 AI인 라마-2를 지원할 계획임을 밝혔다. 퀄컴 칩을 사용하는 스마트폰에 라마-2를 활용한 온디바이스 AI가 탑재되는 것이다. 이는 메타의 라마-2가 오픈 소스를 기반으로 하기에 가능한 것으로, 메타가 LLM 시장에서 후발주자라는 단점을 극복하기 위한 방안 중 하나로 보인다.

이에 더해 퀄컴은 지난 10월 열린 ‘스냅드래곤 서밋 2023’에서 온디바이스 AI를 강조하며 새로운 AI PC용 SoC(Systemon Chip) ‘XElite’를 소개했다. 이러한 X-Elite를 탑재한 PC는 2024년 중반부터 출시될 예정이며 Microsoft Surface, Lenovo, HP, DELL, Asus, Acer, Samsung, Xiaomi 등의 주요 PC 업체가 합류했다.

XElite에는 누비아와 협력하여 만든 ‘오라이온’ CPU가 탑재되었는데 이는 기존 시장에 출시되어 있는 애플 M2맥스 대비 성능은 20% 가량 높고(싱글 스레드 기준), 전력은 30% 적게 사용한다. 이에 더해 이 SoC에는 AI를 위한 전용 NPU를 장착했으며, 130억개 파라미터의 딥러닝 모델까지 지원이 가능하다.

Samsung, Apple, Qualcomm의 AP가 사용되는 스마트폰은 전세계 스마트폰 출하량의 70%(약 8억대)를 차지한다. 물론 이 70%의 스마트폰 전 모델에 AI가 적용되기에는 시간이 필요하겠으나 그 첫번째 모델들이 2024년을 기점으로 동시에 출시가 될 것으로 보인다. 온디바이스 AI가 얼마나 빠른 속도로 우리의 삶에 다가올지는 아직 미지수이다. 하지만 데이터센터 AI에서 온디바이스 AI로의 확장이라는 새로운 AI 산업의 방향성은 명확해보인다. 2024년은 온디바이스 AI와 NPU 확산의 원년이 될 것으로 예상한다.

출처: 현대차증권, Qualcomm, Apple

뜨리스땅

https://tristanchoi.tistory.com/613

CUDA: 소프트웨어 때문에 하드웨어를 못 바꾸나?

프로그래밍 언어, API, 프레임워크를 제공하는 CUDA CUDA(Compute Unified Device Architecture)는 2007년에 출시된 NVIDIA의 소프트웨어 지원 플랫폼으로 프로그래머들이 프로그램을 손쉽게 코딩할 수 있도록 도

tristanchoi.tistory.com

'반도체, 소.부.장.' 카테고리의 다른 글

| NVIDIA(엔비디아) GTC 2024 주요 관전 포인트 (0) | 2024.03.11 |

|---|---|

| 반도체 소부장 - 피에스케이홀딩스 (1) | 2024.03.01 |

| CUDA: 소프트웨어 때문에 하드웨어를 못 바꾸나? (0) | 2024.02.28 |

| NVIDIA GPU의 Core 구조: CUDA Core와 Tensor Core (1) | 2024.02.28 |

| NPU: 딥러닝에 최적화된 칩 (0) | 2024.02.27 |

댓글