1) NVIDIA

A100 Tensor Core GPU는 가속화가 지속되고 있는 데이터 센터 플랫폼에서 전 세대 대비 10배 높은 추론 성능과 새로운 수준의 정밀도 및 가속을 가능하게 하는 3세대 Tensor Core 기술을 제공한다. MIG(Multi-GPU Instance) 기능은 단일 A100을 7개 의 인스턴스로 분할함으로써 각 인스턴스에서 서로 다른 신경망이 실행 가능하며 구조 희소성(Structural Sparsity) 이라는 새로운 특성을 활용하여 추론 AI의 추가적인 가속화를 지원한다.

NVIDIA H100 Tensor Core GPU는 모든 워크로드에 대해 전례 없는 성능, 확장성 및 보안을 제공하며 NVIDIA 4세대 NVLINK 활용 시 워크로드 가속화와 전용 Transformer Engine의 조 단위 Parameter의 언어 모델에 대한 지원 병행이 가능하다.

H100 PCIe GPU 구성에는 NVIDIA Al Enterprise 소프트웨어 제품군이 포함되어 Al 워크로드의 개발 및 배포 과정 간소화가 가능하며, NVIDIA Hopper 아키텍처 활용을 통해 이전 세대에 비해 대규모 언어 모델의 속도를 30배 향상시킨 대화형 AI 제공이 가능하다. H100 NVL GPU를 장착한 시스템의 경우 1,750 억개 Parameter의 LLM(large language model)까지 이전 세대 시스템보다 12배 더 높은 Throughput을 기반으로 GPT3-175B에 대한 추론을 지원한다.

Nvidia가 반도체 AI 분야의 선두주자로 꼽히는 것은 GPU 성능 외에도 Nvidia가 자체 개발한 'CUDA'라는 프로그램 덕분이다. CUDA는 프로그래머가 병렬처리 알고리즘을 쉽게 만들 수 있도록 개발된 프로그램이며 현재 대부분의 AI 알고리즘은 CUDA 플랫폼을 기반으로 한다. CUDA는 Nvidia GPU에서만 작동하기 때문에 Nvidia GPU가 AI반도체 시장에서 점유율을 높이는 데 큰 부분을 CUDA가 견인했다.

실제로 CUDA는 고도로 튜닝된(highly-tuned) Math 라이브러리, 데이터 구조와 알고리즘용 Core 라이브러리, 응용 프로그램의 확장을 위한 통신 라이브러리 등 다양한 라이브러리 프레임워크를 제공한다. 또한 C++, Fortran, Python 등 프로그램 언어를 지원하기 때문에 TensorFlow나 PyTorch와 같은 소프트웨어 라이브러리와 연동성을 통한 높은 확장성을 갖추고 있다.

Nvidia의 GH200은 Nvidia의 현재 최고급 AI 칩인 H100과 동일한 GPU를 가지고 있지만 141Gb의 최첨단 메모리 및 72코어 ARM 중앙 프로세서와 페어링이 가능한 제품이다. AI Inference 용 칩으로 설계된 GH200은 기존 제품 대비 더 많은 메모리 용량을 가지고 있으며, 이에 더 큰 AI 모델이 단일 시스템에 들어갈 수 있다. Nvidia의GH200의 메모리 Capa는 H100의 80GB 메모리 대비 거의 두배에 육박하며 2Q24 Nvidia의 유통업체를 통해 판매될 계획이다.

2) Intel

Goya 추론 프로세서는 하바나의 Tensor-Processing Core(TPC)의 아키텍처를 기반으로 8개의 프로그래밍 코어로 구성된 클러스터를 포함한다. TPC는 딥러닝 워크로드를 지원하도록 설계된 하바나의 독점 코어로써 명령어-셋-아키텍처와 딥러닝 워크로드를 효율적으로 서비스하도록 맞춤화된 하드웨어를 갖춘 VLIW SIMD 벡터 프로세서다. TPC는 기본적으로 FP32, INT32/16/8, UINT32/16/8의 혼합 정밀도 데이터 유형을 지원하며 이를 기반으로 한 Goya는 엣지컴퓨팅에 사용되는 대표적인 NPU(통합 신경 처리 장치)이다.

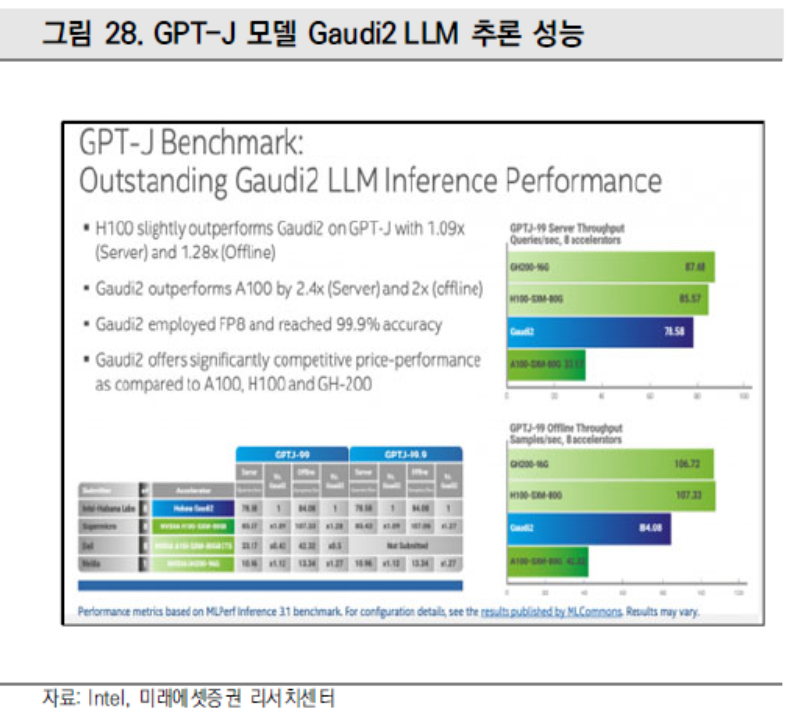

Habana Gaudi2의 경우 생성 AI 및 대형 언어 모델을 훈련하려면 서버 클러스터가 대규모 컴퓨팅 요구 사항을 충족해야 한다. Gaudi2는 384대의 가속기로 GPT-31에 311분이라는 인상적인 훈련 시간을 제공했으며 GPT-3 모델에서 256개에서 384개의 가속기로 거의 선형적인 95% 확장, 컴퓨터 비전(ResNet-508 가속기 및 Unet3D 8 가속기)과 자연어 처리 모델(BERT 8 및 64 가속기)에 대한 우수한 교육 결과를 보여줬다. Gaudi2 11월 제출물 대비 BERT 모델과 ResNet 모델의 성능이 각각 10%, 4% 증가하며 소프트웨어의 성숙도가 상승하고 있는 것을 반증했다.

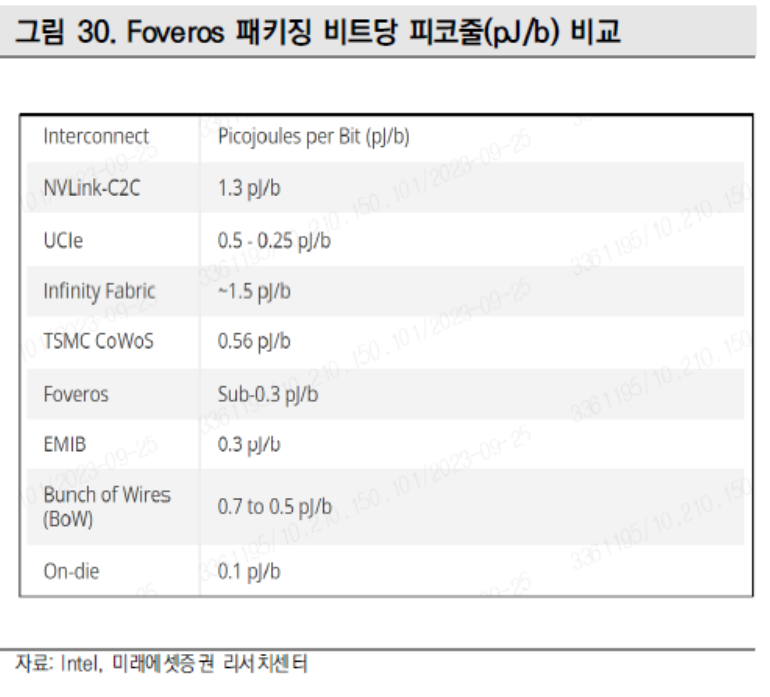

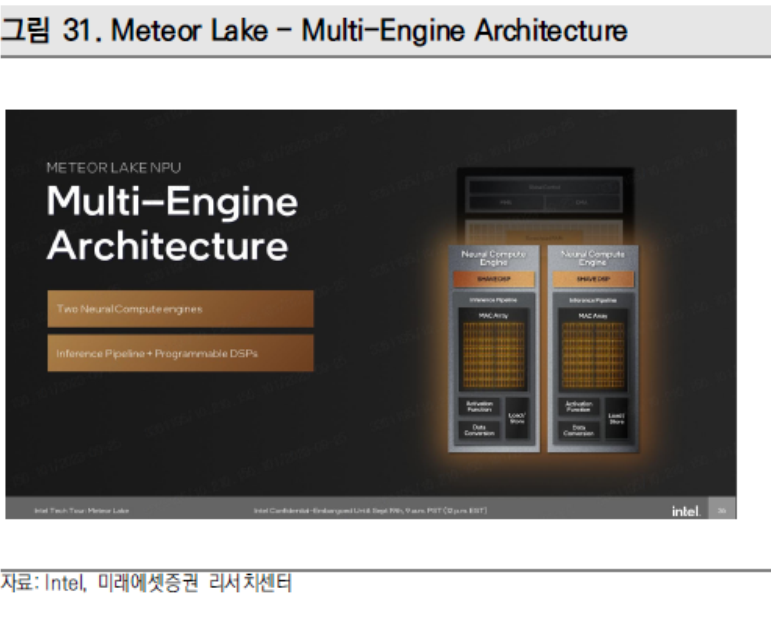

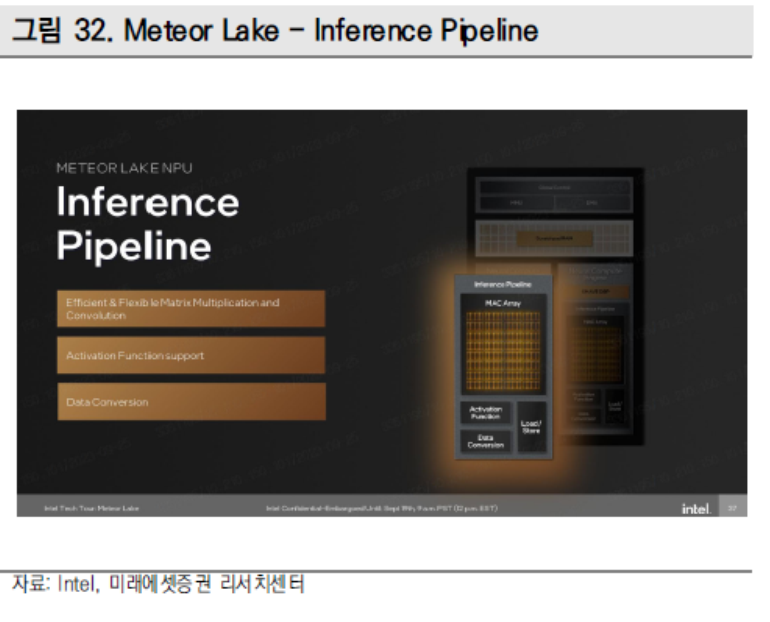

코드네임 메테오 레이크(Meteor Lake)의 PC Inference향 Intel Core Ultra Processor는 인텔의 첫 번째 NPU로써 12월 14일 출시 예정이다. Core Ultra는 Foveros 패키징 기술에 의해 만들어진 최초의 클라이언트 Chiplet 디자인 제품으로서 인텔의 클라이언트 프로세서 로드맵의 변곡점을 기록할 것으로 보인다. Core Ultra는 NPU와 전력 효율적인 성능의 주요한 발전에 더해 내장된 인텔 Arc그래픽 기반 독보적인 수준의 그래픽 성능을 제공할 것으로 보인다.

3) AMD

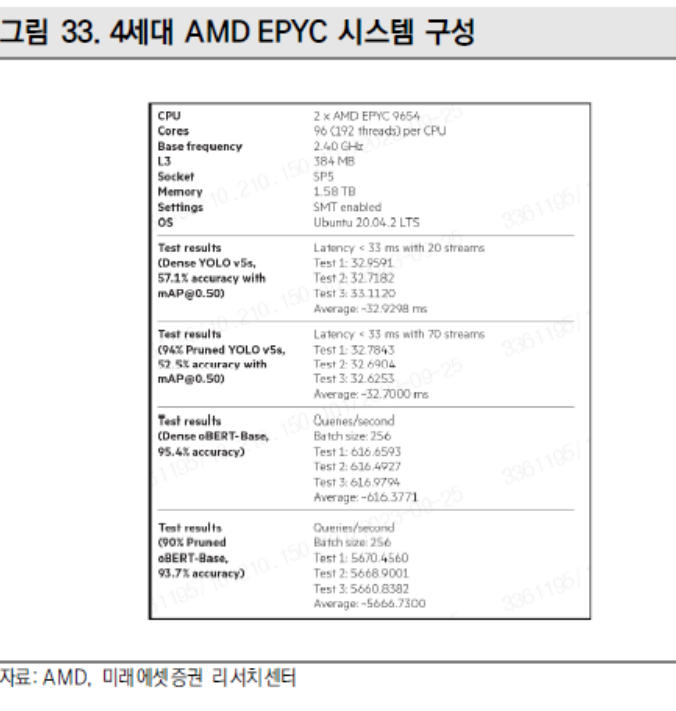

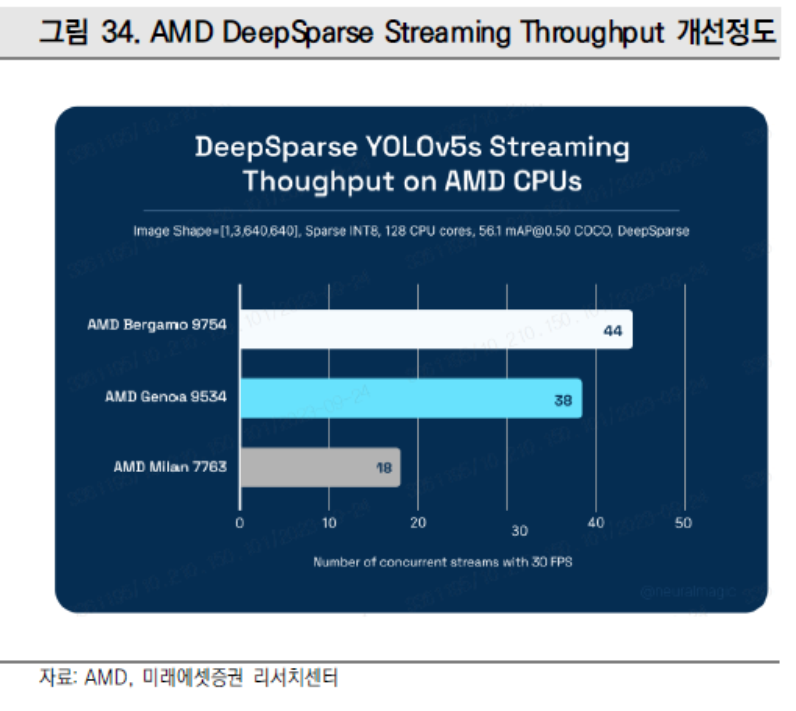

AMD EPYC 9004 Series 프로세서는 YOLOv5s 워크로드에서 "Zen 4c" 코어로 구동되며 이전 4세대 AMD EPYC 프로세서의 성능과 필적할 뿐만 아니라 이를 능가하여 스트림당 최대 33ms(30FPS)의 최대 지연 시간으로 더 많은 이미지 객체 검출 스트림을 구현했다. 더욱 놀라운 것은 4세대 AMD EPYC 프로세서가 보여주는 세대별 개선이다. 3세대 이전 프로세서와 비교할 때 AMD EPYC 프로세서는 2.4배의 성능 향상을 달성했으며 이는 데이터 센터가 DeepSparse를 사용할 때 발생하는 랙/전력/통화 예산의 전체 비용 감축 및 에너지 효율성 최적화를 통해 이루어진 것으로 보인다.

AMD EPYC 97x4 Series 프로세서는 동일한 공간에 더 많은 계산 능력을 담을 수 있는 전력 효율적인 Architecture 채용을 통해 레거시 데이터 센터의 설계 구조로 발생하는 병목현상을 해결한다. 레거시 데이터 센터는 물리적 조건에서 더 많은 고객 워크로드를 처리해야하는 반복적인 문제가 발생하데 AMD EPYC 97x4 Series 프로세서는 이러한 제약을 해결한다. 또한 DDR5 메모리가 서버 비용의 상당 부분을 차지하므로 단일 소켓 설계에서 메모리 레인에 대한 필요성 감소는 코어당 비용 절감에 기여하며 DeepSparse와 결합된 AMD EPYC 97x4 Series 프로세서는 데이터 센터에서 달러당 성능을 극대화할 수 있다.

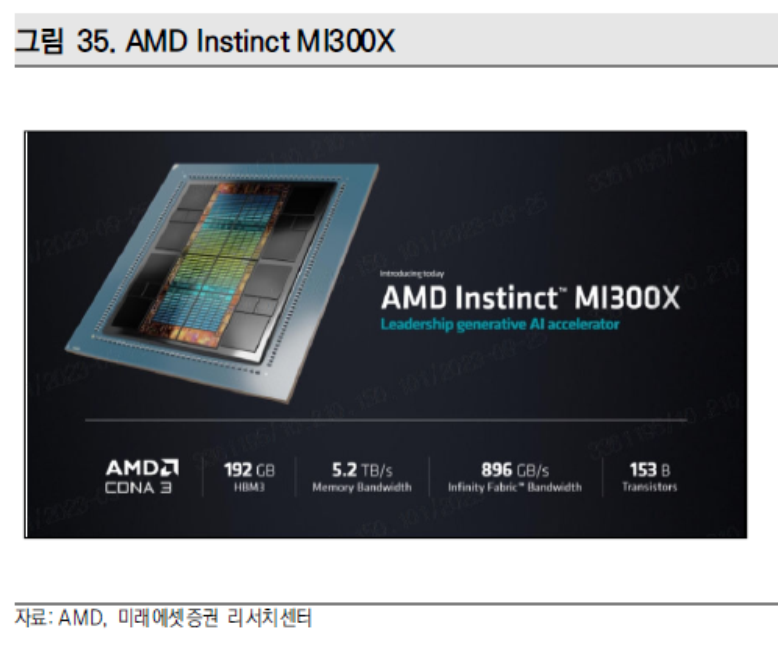

MI300X는 올해 6월에 출시한 AI 애플리케이션용 AMD의 최신형 GPU이다. MI300X는 차세대 AMD CDNA 3 가속기 아키텍처를 기반으로 하며 생성 AI 학습 및 추론과 대형 언어 모델 훈련에 필요한 컴퓨팅 및 메모리 효율성을 제공하기 위해 최대 192GB의 HBM3 메모리를 지원한다. AMD Instinct MI300X의 대용량 메모리로 고객들은 이제 MI300X 가속기5 하나에 400억 parameter 모델인 Falcon-40과 같은 LLM을 장착할 수 있다.

AMD는 MI300A의 Zen4 CPU Chiplet 3개를 추가 CDNA-3 GPU Chiplet 2개로 교체하여 GPU 전용 M1300X를 만들었으며 AI 추론 및 훈련 솔루션을 위해 8개의 MI300X 가속기를 업계 표준 설계로 통합하는 AMD Instinct 플랫폼을 개발하였다.

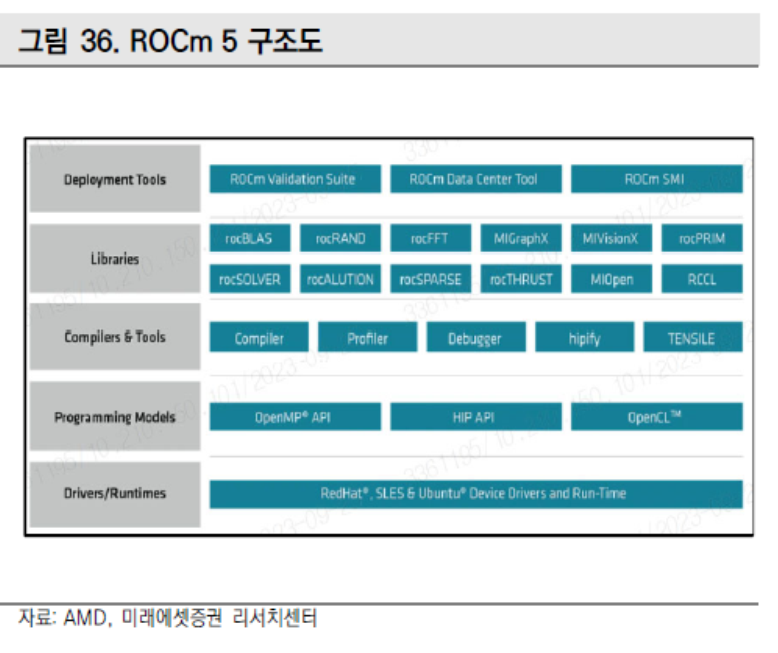

AMD는 NVIDIA의 CUDA 소프트웨어 플랫폼과 경쟁하기 위해 ROCm 소프트웨어 개선 중에 있다. CUDA(Compute Unified Device Architecture)는 NVIDIA의 GPU를 활용하여 성능을 가속화할 수 있도록 하는 NVIDIA의 병렬 컴퓨팅 플랫폼으로서 업계 전문가들은 NVIDIA의 성숙한 소프트웨어 솔루션에 필적하는 AMD의 능력에 대해 회의적인 것으로 보인다. 특히 AMD는 NVIDIA의 소프트웨어에 비해 성능과 AI Tool 적용성 측면에서 열등한 것으로 보인다. 이에 대응하기 위해 AMD는 오픈 소스 전략을 채택하며 소프트웨어 Tool 개발에 집중하고 있다.

4) Qualcomm

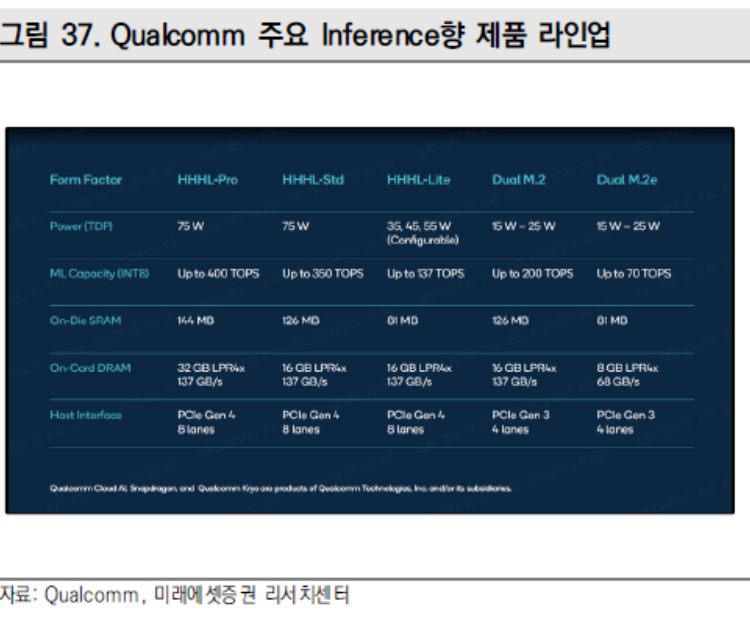

Cloud AI 100은 고급 신호 처리 및 최첨단 전력 효율성으로 데이터 센터, Cloud Edge, Edge Appliance 및 5G 인프라를 포함한 여러 환경을 위한 인공지능(AI) 솔루션을 지원한다. Qualcomm은 저전력, 고성능 및 더 높은 성능/TCO$ 구동에 대한 AI Edge 시장의 요구 사항을 해결하기 위해 35-55W 열 설계 전력(TDP)으로 구성 가능한 Qualcomm Cloud AI 100 PCIe-Lite Processor를 출시하였다.

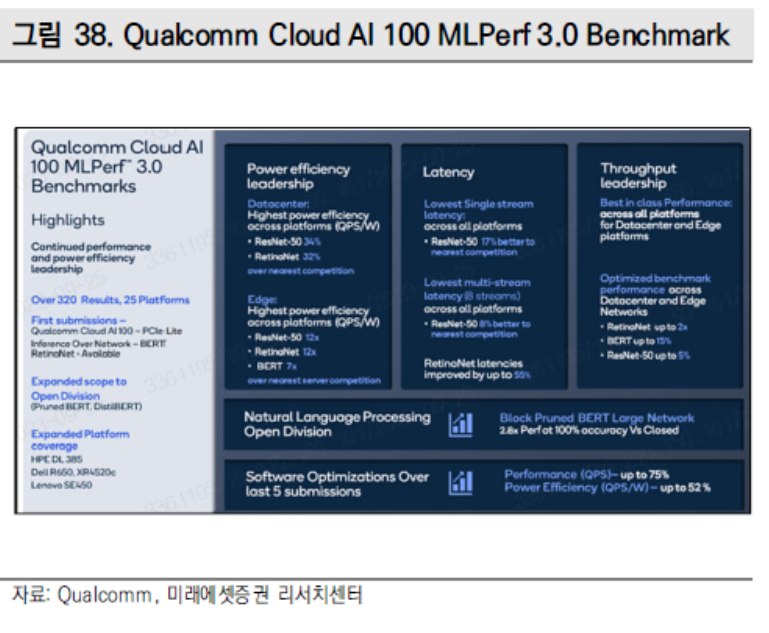

항간에서는 Qualcomm의 Cloud AI 100이 Nvidia의 H100을 성능면에서 앞섰다는 분석이 제기된다. 두 기업의 AI Chip이 이미지 식별과 관련해 와트당 수행하는 쿼리의 수를 테스트한 결과, AI 100이 197.6 쿼리를 수행한 반면 H100은 108.4 쿼리에 그쳤으며 이에 더해 Qualcomm은 객체 탐지 부문에서도 Nvidia에 앞선 것으로 나타났다.

Qualcomm은 지난 11월 차세대 CPU 모델인 Oryon을 발표했다. 이번 PC향 Snapdragon 8cx 4세대 프로세서에 부속 부품으로서 첫 출하가 이루어 질 것으로 보인다. Oryon CPU에 탑재된 새로운 프로세서들은 Hamoa라는 코드네임하에 10월에 공개될 예정이며 1H24 제품 발매가 예상된다.

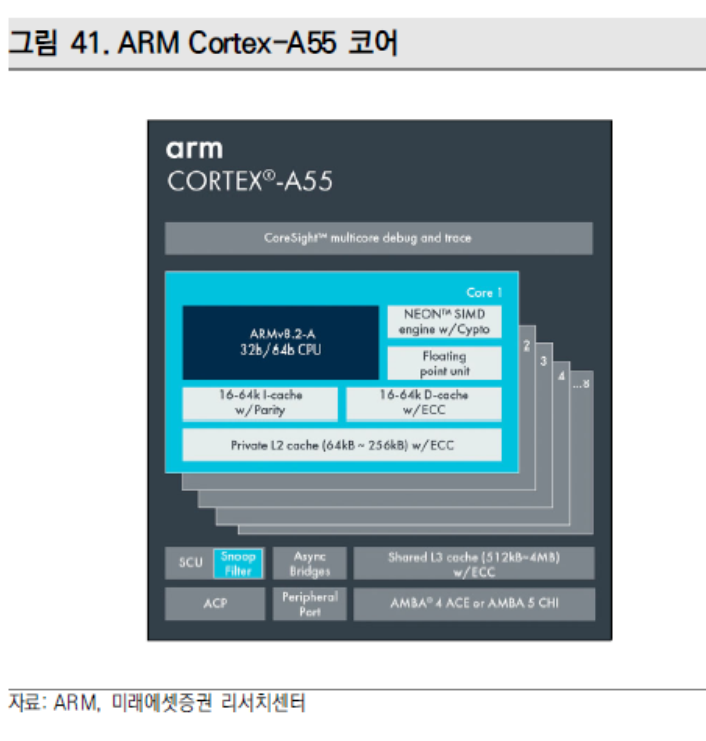

Oryon CPU는 5nm 공정 사용, 12개의 프로그래밍 코어로 구성된 클러스터를 보유하고 있으며 고전력, 저전력 이분화 기능이 가능하도록 2개의 클러스터로 분리된 구조를 보유하고 있다. 고전력 클러스터의 경우 Nuvia의 Arm Architecture를 채택하였으며 저전력 클러스터의 경우 Arm Cortex-A55 코어를 사용할 것으로 보인다. Oryon CPU는 32Gb LPDDR5와 PCle 4세대 Storage까지 지원이 가능할 것으로 보인다.

5) Google

Google Cloud TPU(Tensor Processing Unit)는 번역, 사진, 검색, 어시스턴트, 지메일과 같은 구글 제품들의 동력을 공급하는 목적에 따라 만들어진 기계 학습 가속기 칩이다. LLM과 생성형 AI의 획기적인 발전은 AI 모델을 훈련하고 서비스하기 위해 방대한 연산량을 필요로 하며 증가하는 연산 수요를 비용 효율적으로 충족시키기 위해 구글은 Cloud TPU v5e를 맞춤 설계, 구축 및 배포했다.

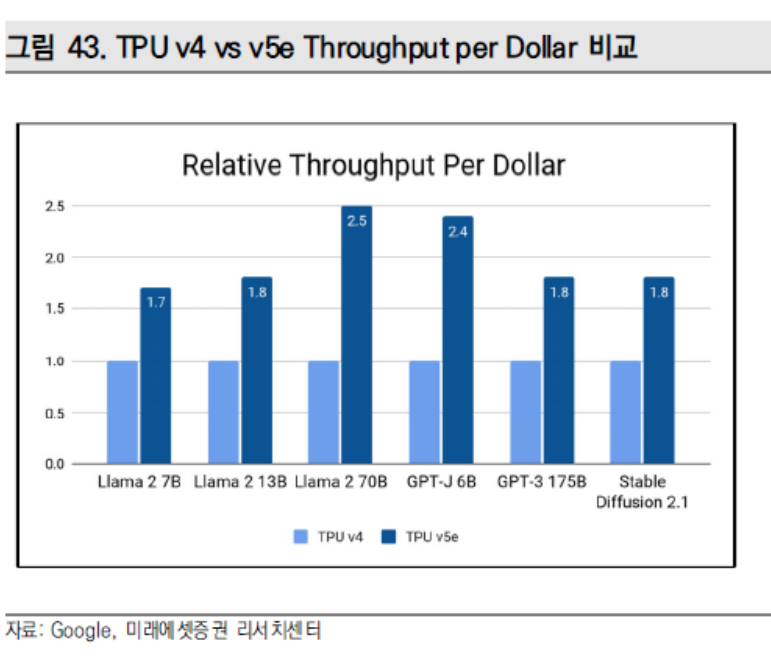

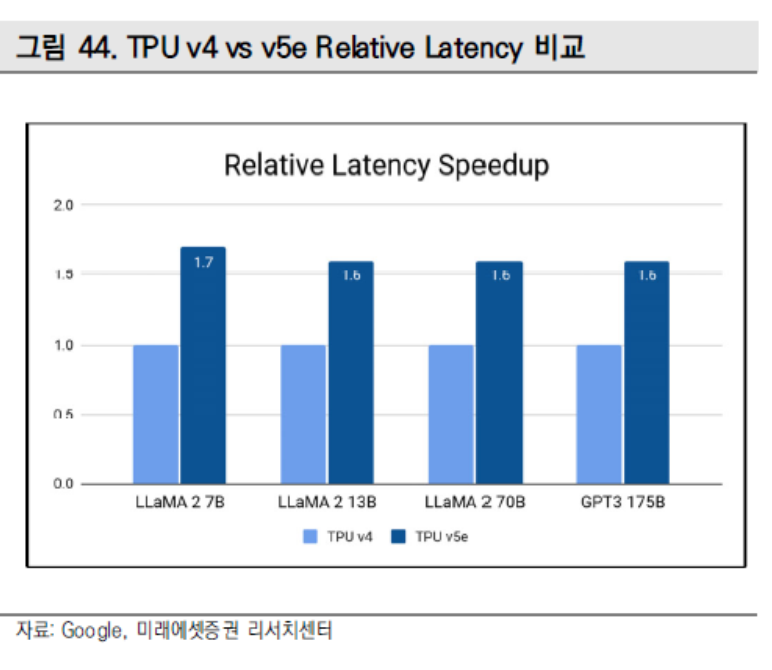

새로운 Cloud TPU v5e는 최신의 대형 언어 모델(LLM)과 생성 AI 모델을 포함한 광범위한 AI 워크로드에 대한 고성능과 비용 효율적인 추론을 가능하게 한다. TPU v5e는 전세대인 TPU v4 대비 달러당 성능은 2.5배 증가하였으며 각각의 TPU v5e 칩은 최대 393조 int8 연산/초를 제공하여 추론 대기 시간을 1.7배 감소시켰다. TPU v5e 포드는 초고속 링크를 통해 네트워크로 연결된 256개의 칩으로 구성되어 있으며 각 TPU v5e 포드는 초당 최대 10조 int8 연산 또는 100 페타옵스(Peta Ops, Peta Operations Per Second)의 연산 능력을 제공한다.

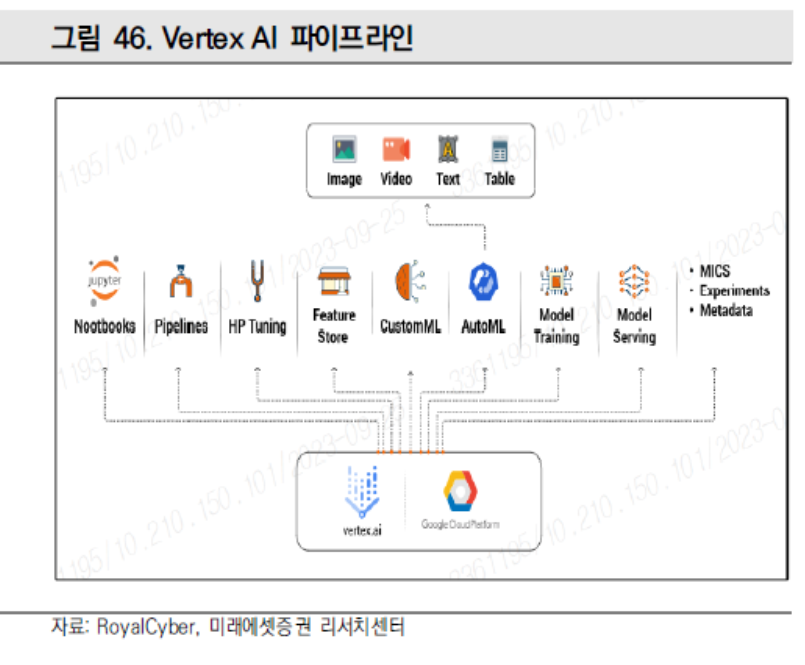

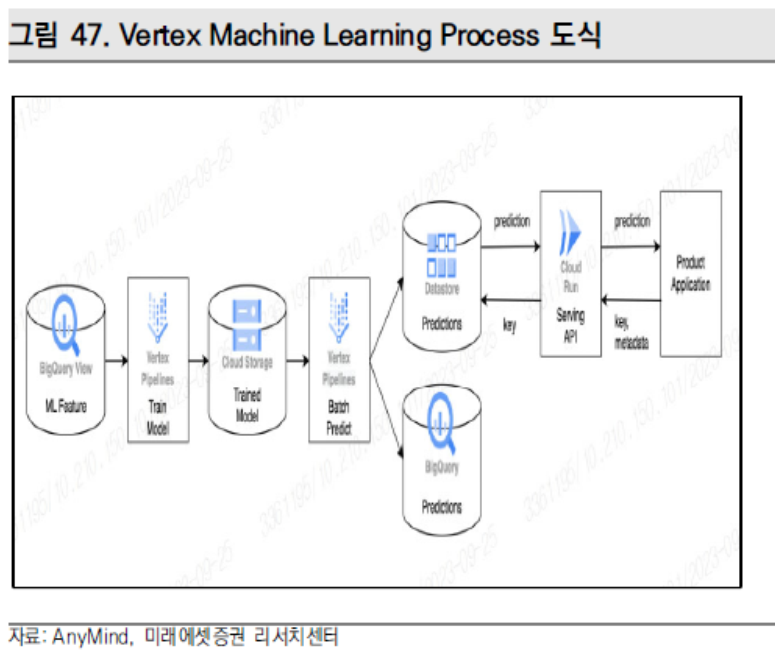

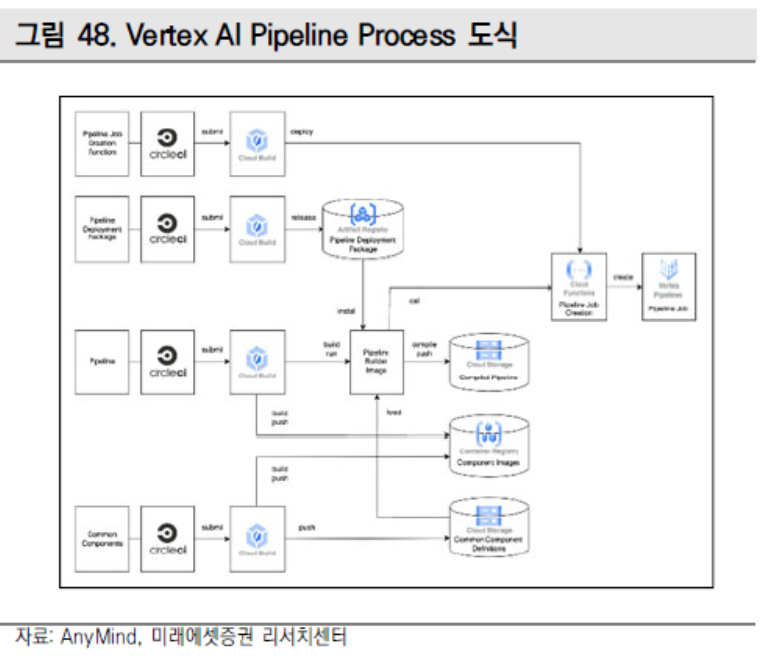

Google의 Vertex AI는 특성 추출부터 모델 학습과 Low-Latency 추론에 이르기까지 데이터 과학자와 AI 개발자가 AI 애플리케이션을 더 쉽게 통합하고 모델의 배포 및 유지 관리를 가속화할 수 있는 관리형 ML 플랫폼이다.

그동안 Google은 수백 가지의 새로운 기능을 더해왔으며 최근 사용가능한 LLM에 Meta의 Llama 2 및 Code Llama, Anthropic의 Claude 2 등을 추가했다. AI 가속기인 Cloud TPU 최신 버전과 Nvidia H100 GPU 인스턴스도 출시하였으며 H100 A3 VM은 이전 세대인 A2 대비 3배 성능 개선이 이루어 진 것으로 보인다. Vertex AI 기반 모델, 검색 및 대화 전반에 걸쳐 작동하는 서비스인 그라운딩 서비스와 데이터 엔지니어링, 분석, 예측 분석 등을 위한 단일 인터페이스 빅쿼리 스튜디오가 추가되었다.

6) Apple

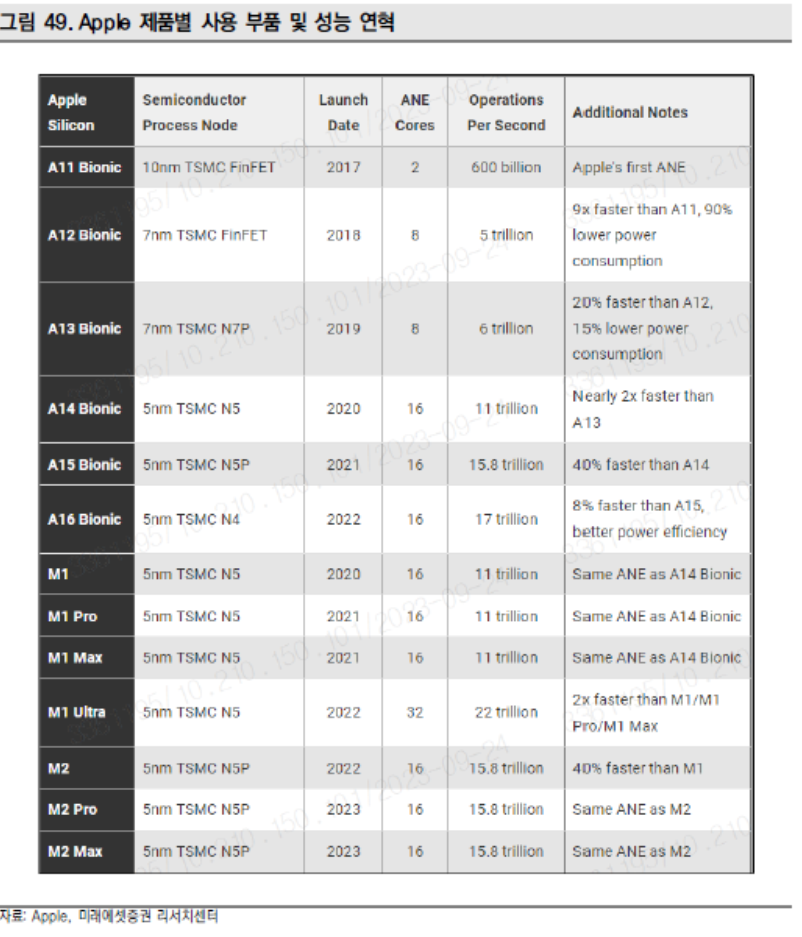

ANE(Apple Neural Engine)는 Apple 기기에서 Deep Neural Network를 에너지 효율적으로 실행하기 위해 최적화된 컴퓨팅 코어 클러스터이다. ML과 AI 알고리즘을 가속화해 메인 CPU나 GPU보다 빠른 속도와 높은 메모리, 전력 효율성의 장점을 제공한다.

2022년, M1 Ultra는 UltraFusion이라 불리는 애플의 맞춤형 Interconnect를 사용하여 두 개의 M1 Max 칩을 단일 패키지로 결합했다. ANE 코어(32개)의 두 배를 가진 M1 Ultra는 ANE 성능을 기존 대비 두 배인 초당 22조 동작으로 늘렸다. 2022년 Apple A16은 TSMC의 향상된 N4 노드를 사용하여 제조되었으며, A15의 ANE에 비해 ANE 성능이 약 8% 개선되었다. 2023년 M2 MAX 제품에 있어 M2와 동일한 ANE를 사용한 것으로 보이며 최근 기술 동향 특이사항은 없는 것으로 보인다.

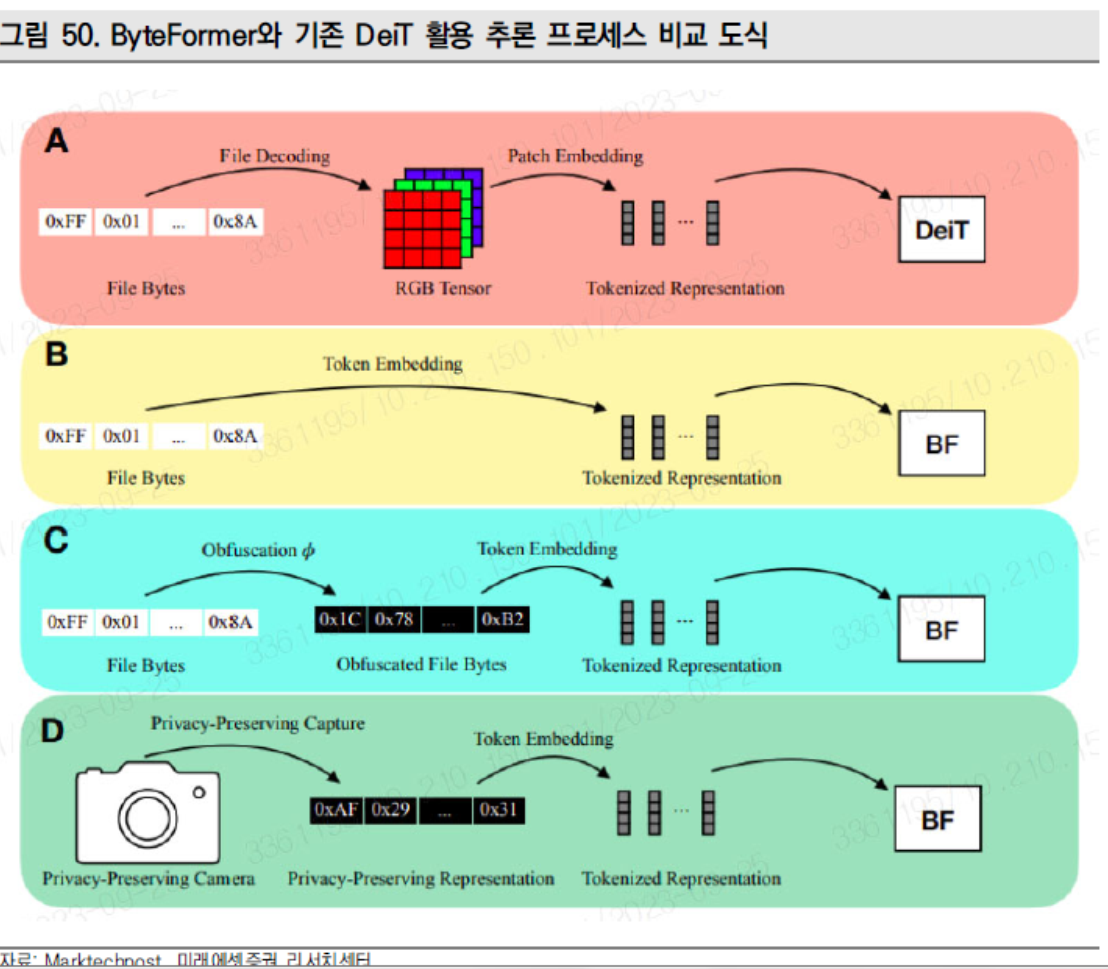

Apple 개발자들이 개발한 ByteFormer는 Vision-Language Transformer AI 모델로서 TIFF 형식으로 저장된 데이터를 사용하며 ImageNet 분류에 있어 약 77.33%의 정확도를 보였다. 해당 모델은 DeiT-Ti Transformer Backbone Hyperparameters를 사용하며, RGB 입력에서 72.2%의 정확도를 기록했다. 또한 아키텍처의 수정 혹은 Hyperparameter의 조정 없이 음성 명령 v2에서 최첨단 수준인 98.7%의 근사치인 95.8%의 정확도에 더해 특유의 input 방식으로 인해 높은 보안성까지 보유했다.

7) Graphcore

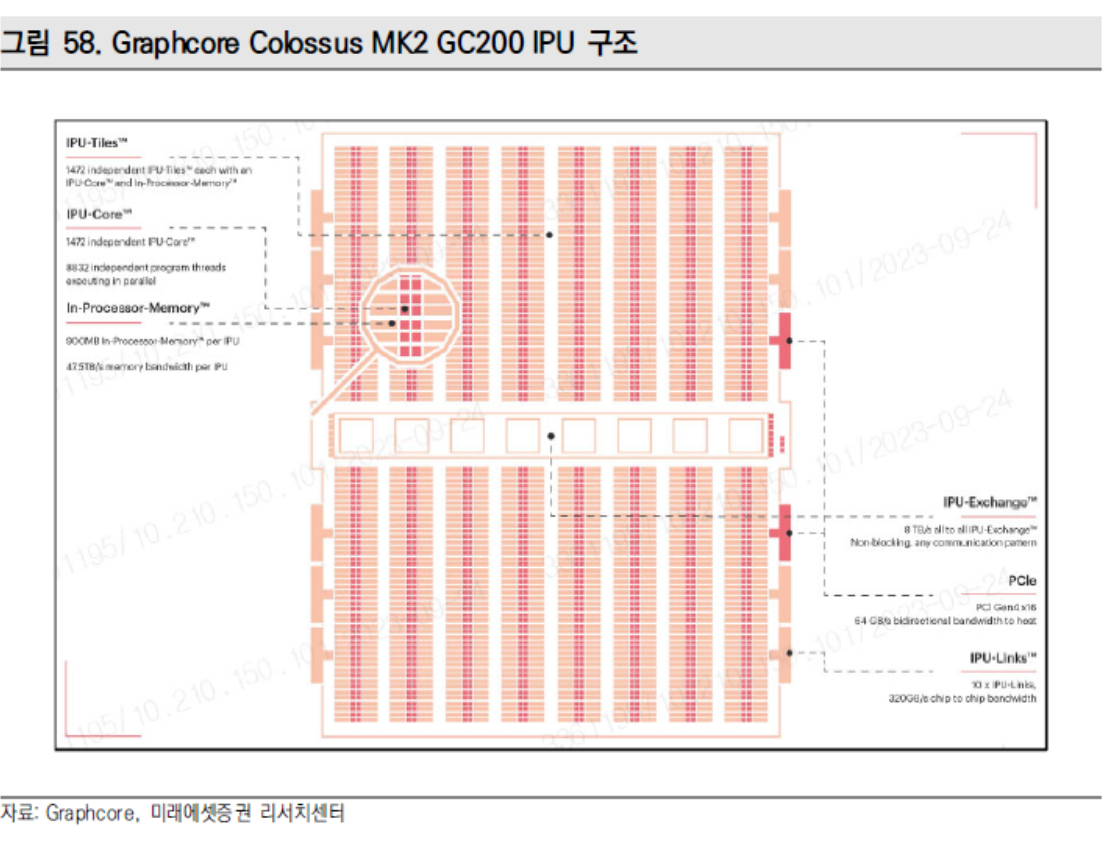

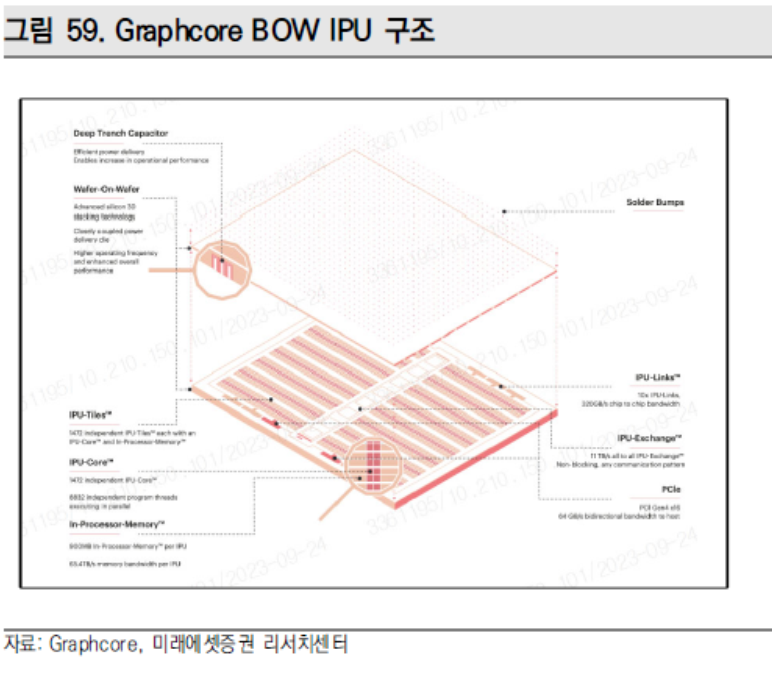

Colosus MK2 GC200 IPU는 2세대 Colosus MK2 IPU 프로세서로서 Poplar SDK와 공동 설계된 새로운 종류의 대규모 병렬 프로세서이다. 1세대 Colosus IPU 출시 이후 동사는 실리콘 및 시스템 아키텍처에서 컴퓨팅, 통신, 메모리 분야에서 MK1 IPU 대비 성능을 8배 향상시킨 Colosus MK2 GC200 IPU를 출시했다.

594억개의 트랜지스터를 갖추고 가장 최신 TSMC 7nm 공정을 사용하여 제작된 Colosus MK2 GC200 IPU에는 1,472개의 프로세서 코어가 있으며 약 9,000개의 독립적인 병렬 프로그램 스레드를 실행한다. 각 IPU는 FP16.16 및 FP16.SR에서 250 테라플롭스의 AI 컴퓨팅이 가능한 전례 없는 900MB In-Processor-Memory를 보유하고 있다. GC200은 타 프로세서 대비 독보적으로 많은 FP32 컴퓨팅을 지원한다.

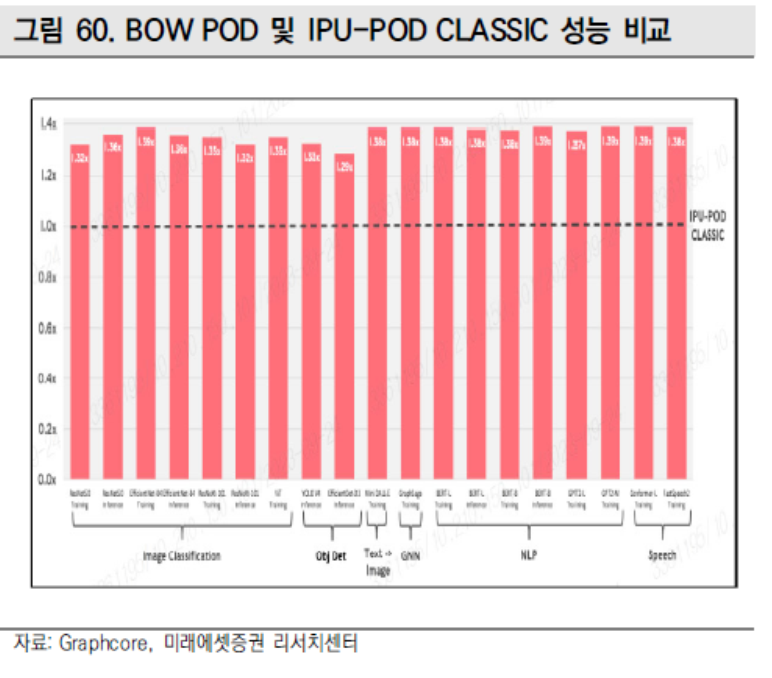

BOW IPU는 세계 최초로 웨이퍼 온 웨이퍼(WoW) 3D 스태킹 기술을 사용하는 프로세서로 개별 IPU의 성능을 한 단계 끌어올린 제품이다. 연산 아키텍처와 실리콘 구현, 통신 및 메모리의 획기적인 발전을 특징으로 하는 BOW IPU는 최대 1.4페타플롭스의 AI 연산을 제공하며, 이전 세대의 IPU 대비 40%의 성능 개선과 전력 효율을 16% 증가시켰다.

BOW 제품 라인업에는 Bow Pod16, Bow Pod64, Bow Pod256이 있다. Bow Pod16은 4페타플롭의 연산성능을 보유하였으며 IPU 시스템을 통해 높은 성능과 적용성을 보유하였다. Bow Pod64는 학습 및 추론 워크로드에 모두 사용 가능한 16페타플롭의 AI 연산 성능을 보유함에 대규모 AI에 적합하게 설계되었다. BOW Pod64의 경우 16 페타플롭의 AI 연산 성능을 제공하는 Bow Pod64는 학습 및 추론 워크로드에 모두 사용 가능하도록 설계되었다.

10) ARM

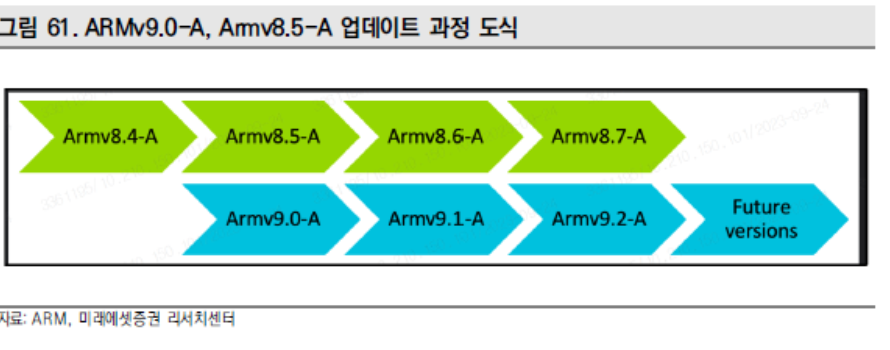

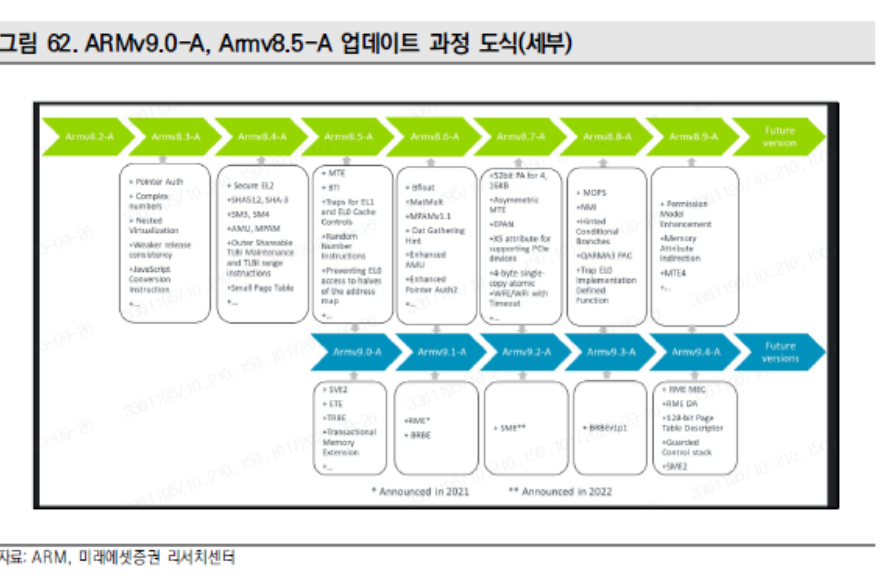

Armv9-A는 이전 세대 Armv8-A을 기반으로 만들어진 Arm Architecture의 최신 버전으로서 Scalable Vector Extension 2(SVE2), Transactional Memory Extension(TME), Branch Record Buffer Extension (BRBE), Embedded Trace Extension(ETE), Trace Buffer Extension(TRBE)와 같은 새로운 기능들을 추가했다.

Arm은 아키텍처에 대한 매년 업데이트를 게시하며 새로운 명령어와 기능을 추가한다. Armv9.0-A는 Armv8.5-A와 일치하며 Armv8.5-A의 모든 기능을 이어받고 새로운 기능을 추가하며 Armv9-A의 초기 출시 이후에는 Armv8-A와 Armv9-A가 함께 업데이트된다.

Ethos NPU 제품들은 확장성이 뛰어난 高효율 2세대 ML 추론 프로세서로서 여러 시

장 부문에서 저렴한 비용으로 프리미엄 AI 솔루션 구축에 활용된다. 특히 확장성과 효

율성이 뛰어난 Arm의 2세대 NPU Ethos-N78은 다중 코어 기술을 통해 싱글 코어

성능을 2.5배 증가시켰다.

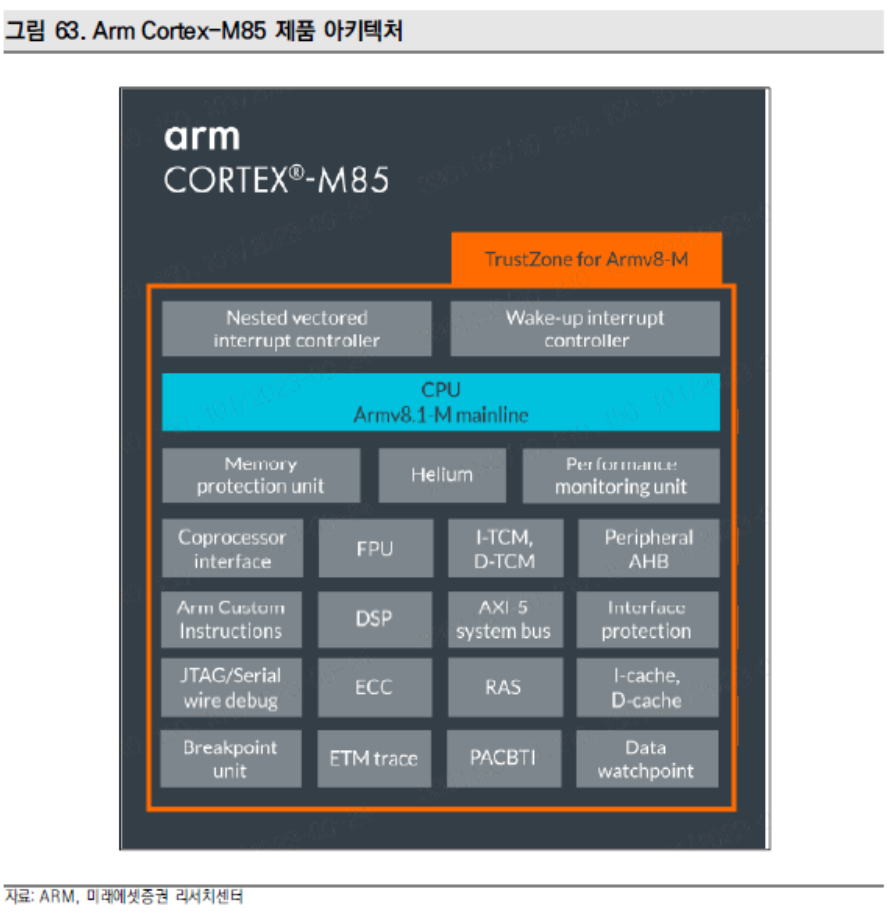

Arm Cortex-M85는 Arm Helium 기술이 적용된 최고 성능의 Cortex-M 프로세서이

며 Cortex-M 기반 자연스러운 업그레이드 경로를 제공한다. Arm TrustZone 기술 외

에도 Cortex-M85는 새로운 보안 및 안전 기능을 기반으로 응용 프로그램 연결 및 활

용 시 Cortex-M에서 가장 높은 수준의 보안을 제공한다.

출처: 미래에셋증권

뜨리스땅

https://tristanchoi.tistory.com/644

생성형 AI를 위한 반도체 기술 trend 1/2

1. AI 추론 시장의 성장성 1) 학습(Training)과 추론(Inference)의 계산방식 차이 학습은 AI 모델이 주어진 데이터와 그 결과값을 이용해 여러가지 변수들 가운데 최적의 가중치(파라미터)를 찾는 과정이

tristanchoi.tistory.com

'반도체, 소.부.장.' 카테고리의 다른 글

| 반도체 장비 - 이오테크닉스 1/2 (0) | 2024.05.06 |

|---|---|

| 생성형 AI를 위한 반도체 기술 trend 1/2 (0) | 2024.04.14 |

| 클라우드 시장의 AI 중심의 재편 (0) | 2024.04.08 |

| 엔비디아(NVIDIA)의 쿠다(CUDA) 지배력은 영원할까? (0) | 2024.03.30 |

| SK하이닉스 - HBM 막차 떠난다 (0) | 2024.03.29 |

댓글