인공지능은 인지-판단-제어에 있어 가장 중요한 ‘로봇의 뇌’에 해당한다.

인공지능 (AI: Artificial Intelligence)은 인간이 가지고 있는 지적 능력을 컴퓨터에서 구현하는 다양한 기술이나 소프트웨어, 컴퓨터 시스템 등을 함께 일컫는 단어다.

1956 년 미국 다트머스 대학에서 열린 학회에서 존 매카시가 처음 ‘인간의 지능을 흉내낸 컴퓨터의 지능’이라고 인공지능을 정의한 이후 오랜기간 개념을 정립해왔다. 그러던 것이 2006 년들어 토론토 대학의 제프리 힌턴 교수가 인공신경망 논문을 쓰면서 학계는 센세이션하게 이를 받아들였고, 빠르게 딥러닝이 인공지능의 중심으로 자리잡게 된다.

지난 2020 년에는 OpenAI 가 GPT-3 라는 초거대규모 언어모델을 내놓으면서 인공 신경망을 통한 학습은 대중화되었다. 이젠 Transformer 알고리즘이 자연어 처리를 넘어 비전 처리에도 활용되고 있다. 또한 강화학습은 과거 알파고의 바둑에서 더 나아가 로봇의 이동 및 매니퓰레이터 학습에 사용되고 있다.

이렇듯 새로운 인공지능의 학습 방법 및 모델은 기존 모델 및 알고리즘이 해결하지 못하는 문제를 새롭게 해결하며 발전해왔다.

로봇이 인간을 대신하기 위해서 학습해야할 내용은 실로 방대하다. 로봇이 마주하는 수많은 객체 인식에 대한 비전 처리 학습, 사람의 음성명령을 이해하는 자연어 처리 알고리즘, 위치 이동 및 작업을 위한 강화학습 등은 가장 많이 사용되고 또 앞으로 더 많은 발전이 필요한 분야다.

(1) 사람처럼 학습한다. Neural Network

인공신경망 (Artificial Neural Network)은 1958 년 프랑크 로젠블럿이 제시한 퍼셉트론(Perceptron)이란 개념에서 출발한다. 퍼셉트론은 인간의 뇌 신경을 모방한 인공신경 뉴런으로 다수의 입력값으로 하나의 결과값을 얻어내는 알고리즘이다.

사람의 신경망이 그러하듯 N 개의 입력값을 일정한 프로세스 속에 넣어 결과값을 도출하고, 이에 근거해 판단하는 일련의 과정을 말한다. 하지만 퍼셉트론은 당시 컴퓨터 과학에서 반드시 필요하다고 여겨지던 선형분리방식을 만족하지 못했다. 즉 입력값과 결과값을 모두 컴퓨터 언어인 0,1 과 같은 선형으로 깔끔하게 표현하지 못하고, 애매한 비선형적으로 표현할 수 밖에 없었던 것이다.

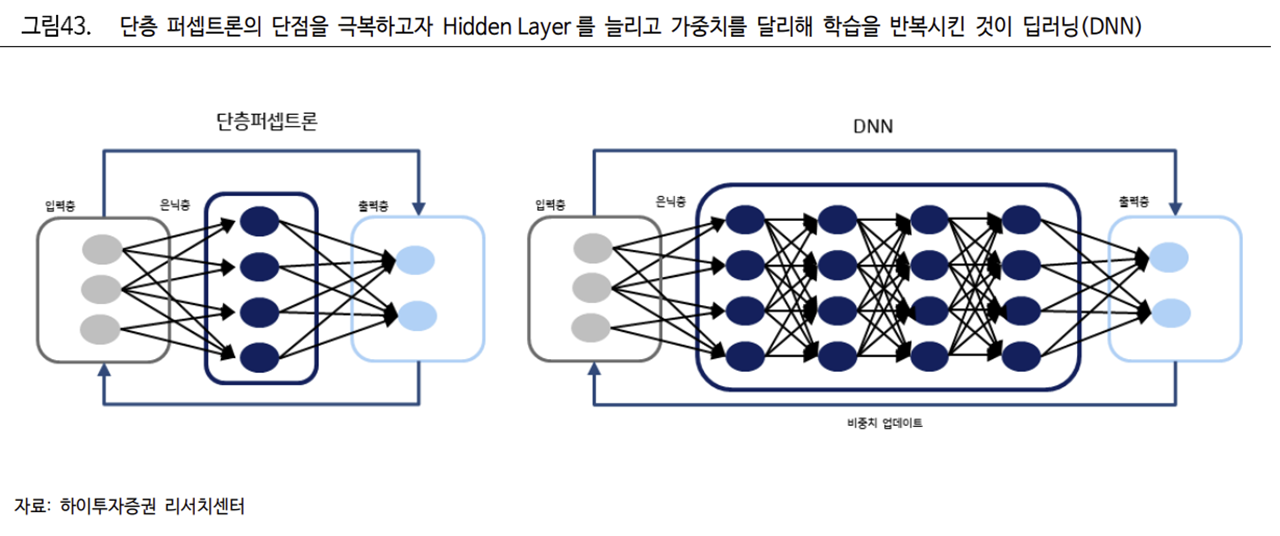

이에 1980 년대에 다층 퍼셉트론이 탄생해 비선형성을 극복하며 인공신경망을 본격적으로 인공지능의 학습에 활용하는 분기점 역할을 하였다. 단층 퍼셉트론을 n 개 이상 Layer 의 다층 퍼셉트론을 만들었고, 비선형성을 표현하는 활성화 함수에 가중치를 곱해 출력값을 선형적으로 컴퓨터에 표현할 수 있게 되었다.

이러한 다층 퍼셉트론은 몇 개의 은닉층 (Hidden Layer)으로 구성된다. 은닉층이 2 개 이상인 신경망 구조를 ‘깊은 학습’, 즉 딥러닝(DNN)이라고 부른다. DNN 은 입력층, 은닉층, 출력층으로 사람의 신경망처럼 각 Layer 를 구성하며, 뇌처럼 학습한다.

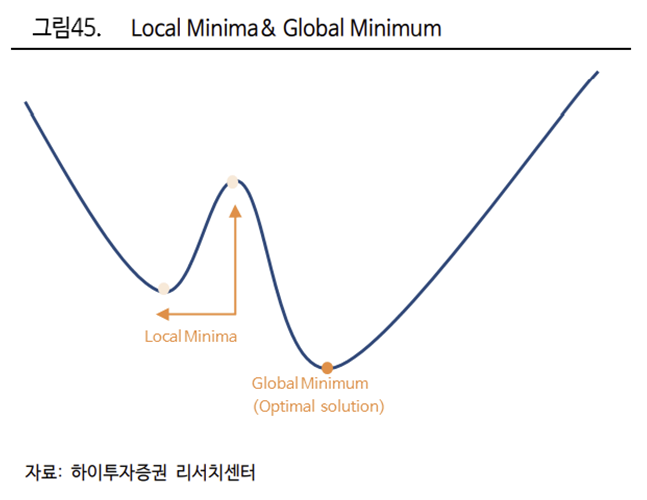

우리가 공부를 할 때 한번 보고 모든 것을 암기할 수 없듯, DNN 을 사용하는 인공지능도 마찬가지다. 처음 설정한 가중치로 한번 학습으로 정확한 학습이 완성될 수 없다. 반복 학습을 통해야 한다. DNN 은 가중치를 조정하며 최적의 가중치를 찾을 때까지 반복학습을 한다. 특히 DNN에서는 최적의 가중치를 찾기 위해 초기의 가중치에서 값을 점차적으로 업데이트하여 정확한 값을 찾아가는 경사하강법을 사용한다. 그러나 이러한 경사하강법은 이론상 Local Minima (극소값)를 Global Minimum (극대값)으로 잘못 인식하여 올바른 가중치를 찾지 못할 수 있다는 단점이 존재하기도 한다.

다만 실제 학습에서는 Momentum, NAG, Adam 등의 확률적 경사하강법으로 이를 해결하고 있다. 이와 같이 딥러닝은 사람의 신경망을 본뜬 AI 학습 알고리즘을 구축해 구동된다. DNN 은 비선형관계를 설명할 수 있다는 장점이 있는 반면, 은닉층 Layer 증가에 따른 Overfitting 의 문제가 발생할 수 있다.

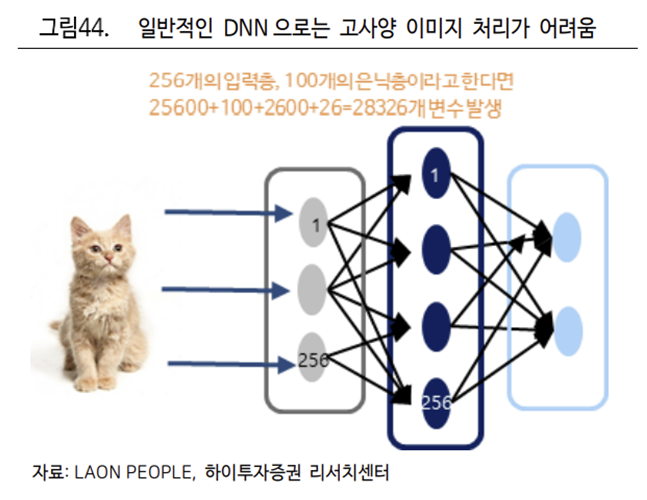

현재 인공지능에 가장 많이 사용하는 이미지 처리 및 자연어 처리의 학습을 위해서는 이미지의 픽셀과 문장의 단어 벡터를 1 차원의 형태로 DNN 에 투입하게 된다. 데이터 크기가 큰 이미지와 단어의 특성 때문에 이를 처리하기 위한 Layer 수가 크게 증가하게 된다. 증가한 은닉층의 Layer 는 많은 데이터를 학습시키고 정확도를 높일 수는 있지만, 동시에 필요 이상으로 시간 및 비용이 증가해 현실적인 어려움이 있다.

2012 년 Imagenet 챌린지에서 CNN(ConvolutionNN: 합성곱신경망)을 활용한 Alexnet 이 등장하며 이미지 처리 분야에 큰 존재감을 드러낸 이후, CNN 은 가장 범용적인 인공지능으로 자리잡았다. CNN 은 은닉층을 사용하는 대신 Convolution Layer 를 사용하여 이미지의 픽셀 단위를 1 차원으로 변환하지 않고 2 차원 픽셀 그대로 학습을 진행한다.

DNN 과 달리 CNN 에서는 각 Layer 에 존재하는 Filter 와 Convolution Layer 의 연산 비중을 점차 수정하는 방법으로 학습을 진행한다. 이를 통해 1 차원 데이터로 변환하는 과정에서 발생했던 데이터 소실이 발생하지 않고, 변환 과정에서 발생한 비용과 시간을 절약했으며, 학습 속도 또한 획기적으로 개선할 수 있었다.

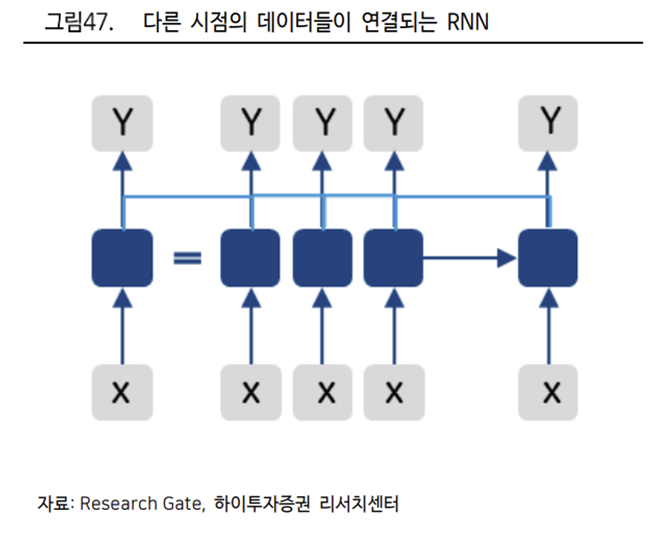

이미지 뿐 아니라 자연어 처리(NLP)에도 효과가 크다. NLP 를 위해서 가장 중요한 것은 단어 및 문장의 Context 를 파악하는 것이다. 문장은 순서 관계를 가지는 공간 데이터인 단어로 구성된다. 예를 들어 ‘나는 사과를 갖고 싶다’ 라는 문장에서 사람들은 ‘갖고 싶다’라는 서술어에 호응되는 사과의 뜻은 ‘먹는 사과’라는 것을 알 수 있다. 하지만 학습이 이루어지지 않은 인공지능은 모른다. 따라서 ‘갖고 싶다’라는 서술어는 반성의 ‘사과’가 아니라 먹는 ‘사과’와 호응한다는 문맥을 학습시켜야 한다.

RNN(Recurrent Neural Network)과 LSTM(Long Short Term Memory)은 이를 위해 데이터를 입력한 서로 다른 투입 시점의 데이터들이 피드백 연결된 구조를 가진다. 이를 통해 문장 학습시 문맥 정보 또한 함께 학습하게 된다.

https://www.youtube.com/watch?v=4DP6qpruXm8

출처: 하이투자증권, Research Gate, ILSVRC, 라온피플, Gartner

뜨리스땅

https://tristanchoi.tistory.com/385

로보틱스 기술 탐구: 인공지능 용어 정리

새로운 개념들이 많아서 정리해보았습니다. 퍼셉트론(Perceptron) 1958 년 프랑크 로젠블럿이 제시한 인공 신경망의 초기 개념이다. 인간의 뉴런이 신호를 주고받는 방식에서 노드를 착안하여 사람

tristanchoi.tistory.com

'로보틱스' 카테고리의 다른 글

| 로봇 기술 탐구: 로봇의 뇌(인공지능) 어디까지 왔나? - 3 (강화학습) (0) | 2022.12.31 |

|---|---|

| 로봇 기술 탐구: 로봇의 뇌(인공지능) 어디까지 왔나? - 2 (자연어 처리) (0) | 2022.12.31 |

| 로봇 기술 탐구: 인공지능 용어 정리 (1) | 2022.12.30 |

| 로봇 산업 탐구: 5. 테크기업들의 진출 - 네이버 (0) | 2022.08.25 |

| 로봇 산업 탐구: 5. 테크기업들의 진출 - 현대차 (0) | 2022.08.24 |

댓글